آنچه خواهید خواند

NPU گوشی، بررسی چالشهای هوش مصنوعی روی دستگاه

کوچکسازی هوش مصنوعی برای گوشی شما کار آسانی نیست. NPU گوشی شما ممکن است کاربرد چندانی نداشته باشد. تقریباً تمام نوآوریهای تکنولوژیک در سالهای اخیر بر یک چیز تمرکز لیزری داشتهاند: هوش مصنوعی مولد. بسیاری از این سیستمهای بهظاهر انقلابی روی سرورهای بزرگ و گرانقیمت در مراکز داده اجرا میشوند، اما در عین حال، سازندگان تراشه درباره قدرت واحدهای پردازش عصبی (NPU) که به دستگاههای مصرفکننده آوردهاند، به خود میبالند.

هر چند ماه یکبار، همین وضعیت تکرار میشود: این NPU جدید 30 یا 40 درصد سریعتر از مدل قبلی است. قرار است این سرعت به شما امکان انجام کارهای مهمی را بدهد، اما هیچکس واقعاً توضیح نمیدهد که آن کار چیست. کارشناسان آیندهای از ابزارهای هوش مصنوعی شخصی و امن با هوش روی دستگاه را تصور میکنند، اما آیا این با واقعیت رونق هوش مصنوعی مطابقت دارد؟ هوش مصنوعی «در لبه» (edge) عالی به نظر میرسد، اما تقریباً هر ابزار هوش مصنوعی مهمی در فضای ابری اجرا میشود. پس آن تراشه در گوشی شما اصلاً چه کاری انجام میدهد؟

NPU چیست؟

شرکتهایی که محصول جدیدی را عرضه میکنند، اغلب درگیر اغراق و اصطلاحات بازاریابی مبهم میشوند، بنابراین در توضیح جزئیات فنی ضعیف عمل میکنند. برای بیشتر افرادی که گوشی میخرند، مشخص نیست که چرا به سختافزار برای اجرای حجم کاری هوش مصنوعی نیاز دارند، و مزایای ادعایی تا حد زیادی نظری هستند.

بسیاری از پردازندههای پرچمدار مصرفکننده امروزی سیستم-روی-تراشه (SoC) هستند، زیرا چندین عنصر محاسباتی مانند هستههای CPU، پردازندههای گرافیکی (GPU) و کنترلکنندههای تصویر را روی یک قطعه سیلیکون واحد ادغام میکنند. این موضوع در مورد قطعات موبایل مانند اسنپدراگون کوالکام یا تنسور گوگل، و همچنین قطعات کامپیوتر مانند اینتل Core Ultra صادق است.

NPU یک افزونه جدیدتر به تراشهها است، اما یک روزه ظاهر نشده ریشهای دارد که ما را به اینجا رسانده است. NPUها در کاری که انجام میدهند خوب هستند، زیرا بر محاسبات موازی تأکید دارند، که در سایر اجزای SoC نیز مهم است.

کوالکام زمان قابل توجهی را در رویدادهای معرفی محصولات جدید خود به صحبت درباره NPUهای هگزاگون اختصاص میدهد. ناظران دقیق ممکن است به یاد داشته باشید که این نام تجاری از خط تولید پردازندههای سیگنال دیجیتال (DSP) این شرکت بازیافت شده است، و دلیل خوبی برای این کار وجود دارد.

وینش سوکومار، رئیس محصولات هوش مصنوعی کوالکام، گفت: «سفر ما به پردازش هوش مصنوعی احتمالاً 15 یا 20 سال پیش آغاز شد، جایی که اولین نقطه اتکای ما بررسی پردازش سیگنال بود.» DSPها معماری مشابهی با NPUها دارند، اما بسیار سادهتر هستند و تمرکزشان بر پردازش صدا (مانند تشخیص گفتار) و سیگنالهای مودم است.

NPU یکی از چندین جزء در SoCهای مدرن است.

با توسعه مجموعه فناوریهایی که از آنها به عنوان «هوش مصنوعی» یاد میکنیم، مهندسان شروع به استفاده از DSPها برای انواع بیشتری از پردازش موازی، مانند حافظه طولانی مدت کوتاه (LSTM) کردند. سوکومار توضیح داد که با شیفتگی صنعت به شبکههای عصبی پیچشی (CNN)، فناوری زیربنای برنامههایی مانند بینایی کامپیوتر، DSPها بر توابع ماتریسی متمرکز شدند، که برای پردازش هوش مصنوعی مولد نیز ضروری هستند.

در حالی که یک ریشه معماری در اینجا وجود دارد، گفتن اینکه NPUها فقط DSPهای فانتزی هستند، کاملاً درست نیست. مارک اودانی، معاون مدیر عامل مدیاتک، گفت: «اگر در اصطلاح کلی کلمه درباره DSPها صحبت کنید، بله، [یک NPU] یک پردازنده سیگنال دیجیتال است. اما همه اینها راه درازی را طی کرده و بسیار بیشتر برای موازیسازی، نحوه کار ترانسفورمرها و نگهداری تعداد عظیمی از پارامترها برای پردازش بهینه شده است.»

با وجود برجسته بودن در تراشههای جدید، NPUها برای اجرای وظایف هوش مصنوعی «در لبه» (edge) اصطلاحی که پردازش محلی هوش مصنوعی را از سیستمهای مبتنی بر ابر متمایز میکند کاملاً ضروری نیستند. CPUها کندتر از NPUها هستند اما میتوانند برخی از وظایف سبک را بدون استفاده زیاد از انرژی انجام دهند.

در همین حال، GPUها اغلب میتوانند دادههای بیشتری را نسبت به NPU پردازش کند، اما برای این کار انرژی بیشتری مصرف میکنند. و به گفته سوکومار از کوالکام، مواقعی وجود دارد که ممکن است بخواهید این کار را انجام دهید. به عنوان مثال، اجرای وظایف هوش مصنوعی در حین اجرای یک بازی میتواند GPU را ترجیح دهد.

سوکومار میگوید: «در اینجا، معیار موفقیت شما این است که نرخ فریم (frame rate) خود را کاهش ندهید، در حالی که رزولوشن فضایی، محدوده دینامیکی پیکسل را حفظ کرده و همچنین قادر به ارائه توصیههای هوش مصنوعی برای گیمر در آن فضا باشید. در چنین مورد استفادهای، اجرای آن در موتور گرافیکی منطقی است، زیرا دیگر نیازی به جابجایی بین گرافیک و یک موتور هوش مصنوعی خاص دامنه مانند NPU ندارید.»

زندگی در لبه دشوار است

متأسفانه، NPUهای بسیاری از دستگاهها بلااستفاده میمانند (و نه فقط در حین بازی). ترکیب ابزارهای هوش مصنوعی محلی در مقابل ابری، به نفع مورد دوم است، زیرا آنجا زیستگاه طبیعی مدلهای زبان بزرگ (LLM) است. مدلهای هوش مصنوعی روی سرورهای قدرتمند آموزش داده و بهینهسازی میشوند و در آنجا بهترین عملکرد را دارند.

یک هوش مصنوعی مبتنی بر سرور، مانند ورژنهای کامل جِمینای (Gemini) و چتجیپیتی (ChatGPT)، مانند مدلی که روی NPU گوشی شما اجرا میشود، محدودیت منابع ندارد. ورژن اخیر مدل جِمینای نانو (Gemini Nano) گوگل روی دستگاه را در نظر بگیرید که دارای یک پنجره متنی 32 هزار توکنی است. این بیش از دو برابر بهبود نسبت به ورژن قبلی است. با این حال، مدلهای جِمینای مبتنی بر ابر دارای پنجرههای متنی تا 1 میلیون توکن هستند، به این معنی که میتوانند حجم بسیار بیشتری از دادهها را پردازش کند.

هم سختافزار هوش مصنوعی ابری و هم سختافزار هوش مصنوعی لبه (edge) همچنان بهتر خواهند شد، اما ممکن است تعادل به نفع NPU تغییر نکند. شناز زک، مدیر ارشد محصول در تیم پیکسل گوگل، گفت: «فضای ابری همیشه منابع محاسباتی بیشتری نسبت به یک دستگاه موبایل خواهد داشت.»

اودانی گفت: «اگر دقیقترین مدلها یا قویترین مدلها را میخواهید، همه اینها باید در فضای ابری انجام شود. اما آنچه ما دریافتهایم این است که در بسیاری از موارد استفاده که فقط خلاصهسازی متنی یا صحبت با دستیار صوتی شماست، بسیاری از این موارد میتوانند در سه میلیارد پارامتر جای بگیرند.»

فشردن مدلهای هوش مصنوعی روی گوشی یا لپتاپ شامل مصالحه است به عنوان مثال، با کاهش پارامترهای موجود در مدل. اودانی توضیح داد که مدلهای مبتنی بر ابر صدها میلیارد پارامتر را اجرا میکنند، که وزندهی تعیینکننده نحوه پردازش توکنهای ورودی توسط مدل برای تولید خروجیها است. در حال حاضر نمیتوانید چیزی شبیه به آن را روی یک دستگاه مصرفکننده اجرا کنید، بنابراین توسعهدهندگان باید اندازه مدلها را برای لبه به شدت کاهش دهند. اودانی میگوید جدیدترین NPU نسل نهم مدیاتک میتواند حدود 3 میلیارد پارامتر را مدیریت کند تفاوتی از چند مرتبه بزرگی.

مقدار حافظه موجود در گوشی یا لپتاپ نیز یک عامل محدودکننده است، بنابراین مدلهای هوش مصنوعی بهینهسازی شده برای موبایل معمولاً کوانتیزه (quantized) میشوند. این بدان معناست که تخمین مدل از توکن بعدی با دقت کمتری اجرا میشود. فرض کنید میخواهید یکی از مدلهای باز بزرگتر، مانند لاما (Llama) یا گما 7b (Gemma 7b) را روی دستگاه خود اجرا کنید.

استاندارد فعلی FP16 است که به عنوان دقت نصف شناخته میشود. در این سطح، یک مدل با 7 میلیارد پارامتر، 13 یا 14 گیگابایت حافظه را اشغال خواهد کرد. کاهش به FP4 (دقت یکچهارم) اندازه مدل را در حافظه به چند گیگابایت میرساند.

سوکومار گفت: «وقتی به فرض بین سه تا چهار گیگابایت فشرده میکنید، این یک نقطه ایدهآل برای ادغام در فاکتورهای فرم محدود از نظر حافظه مانند گوشی هوشمند است. و سرمایهگذاری زیادی در اکوسیستم و در کوالکام برای بررسی روشهای مختلف فشردهسازی مدلها بدون از دست دادن کیفیت انجام شده است.»

ایجاد یک هوش مصنوعی تعمیمیافته با این محدودیتها برای دستگاههای موبایل دشوار است، اما کامپیوترها و به خصوص گوشیهای هوشمند چشمهای از دادهها هستند که میتوانند به مدلها تزریق شوند تا خروجیهای بهظاهر مفیدی تولید کند. به همین دلیل است که بیشتر هوش مصنوعی لبه (edge AI) به سمت موارد استفاده خاص و محدود، مانند تجزیه و تحلیل اسکرینشاتها یا پیشنهاد قرار ملاقاتهای تقویم، گرایش دارد.

گوگل میگوید جدیدترین گوشیهای پیکسل آن بیش از 100 مدل هوش مصنوعی، هم مولد و هم سنتی، را اجرا میکنند.

حتی شکاکان هوش مصنوعی نیز میتوانند تشخیص دهند که چشمانداز به سرعت در حال تغییر است. در زمانی که برای کوچکسازی و بهینهسازی مدلهای هوش مصنوعی برای گوشی یا لپتاپ طول میکشد، ممکن است مدلهای ابری جدیدی ظاهر شوند که آن کار را منسوخ کند.

این همچنین دلیلی است که توسعهدهندگان شخص ثالث در استفاده از پردازش NPU در برنامهها کند عمل کردهاند. آنها یا باید به یک مدل موجود روی دستگاه متصل شوند که شامل محدودیتها و اهداف توسعهای در حال تغییر سریع است، یا مدلهای سفارشی خود را پیادهسازی کند. هیچکدام در حال حاضر گزینه عالی نیستند.

مسئله اعتماد

اگر فضای ابری سریعتر و آسانتر است، چرا باید به زحمت بهینهسازی برای لبه و مصرف انرژی بیشتر با یک NPU پرداخت؟ تکیه بر فضای ابری به معنای پذیرش سطحی از وابستگی و اعتماد به افرادی است که مراکز داده هوش مصنوعی را اداره میکنند، که ممکن است همیشه مناسب نباشد.

سوکومار از کوالکام گفت: «ما همیشه با حریم خصوصی کاربر به عنوان یک عنصر شروع میکنیم.» او توضیح داد که بهترین استنتاج ذاتاً عمومی نیست بلکه بر اساس علایق کاربر و آنچه در زندگی او رخ میدهد، شخصیسازی شده است. تنظیم دقیق مدلها برای ارائه این تجربه نیاز به دادههای شخصی دارد، و ذخیره و پردازش این دادهها به صورت محلی امنتر است.

حتی زمانی که شرکتها در مورد حریم خصوصی در خدمات ابری خود حرفهای درست میزنند، اینها به هیچ وجه تضمینکننده نیستند. فضای دوستانه و یاریرسان چتباتهای عمومی نیز مردم را تشویق میکند تا اطلاعات شخصی زیادی را فاش کند، و اگر آن دستیار در فضای ابری اجرا شود، دادههای شما نیز در آنجا خواهند بود.

نبرد حقوقی اوپنایآی با نیویورک تایمز میتواند منجر به تحویل میلیونها چت خصوصی به ناشر شود. رشد انفجاری و چارچوب نظارتی نامشخص هوش مصنوعی مولد باعث میشود که دانستن سرنوشت دادههای شما دشوار باشد.

اودانی گفت: «مردم از بسیاری از این دستیاران هوش مصنوعی مولد مانند یک درمانگر استفاده میکنند. و شما نمیدانید که روزی ممکن است تمام این اطلاعات در اینترنت منتشر شود.»

همه اینقدر نگران نیستند. زک ادعا میکند که گوگل «امنترین زیرساخت ابری جهان» را ساخته است، که به آن اجازه میدهد دادهها را در جایی پردازش کند که بهترین نتایج را ارائه میدهد. زک از Video Boost و Pixel Studio به عنوان نمونههایی از این رویکرد استفاده میکند و اشاره میکند که فضای ابری گوگل تنها راه برای سریع و باکیفیت کردن این تجربهها است. این شرکت اخیراً سیستم جدید Private AI Compute خود را معرفی کرده که ادعا میکند به همان اندازه هوش مصنوعی محلی امن است.

حتی اگر این درست باشد، لبه (edge) مزایای دیگری دارد هوش مصنوعی لبه صرفاً قابل اعتمادتر از یک سرویس ابری است. اودانی گفت: «روی دستگاه سریع است. گاهی اوقات من با چتجیپیتی صحبت میکنم و وایفای من قطع میشود یا هر چیز دیگری، و یک لحظه مکث میکند.»

خدماتی که مدلهای هوش مصنوعی مبتنی بر ابر را میزبانی میکنند، فقط یک وبسایت نیستند اینترنت امروزی به شدت به هم وابسته است، با شبکههای تحویل محتوا، ارائهدهندگان DNS، هاستینگ و سایر خدماتی که میتوانند در صورت بروز نقص، هوش مصنوعی مورد علاقه شما را دچار مشکل یا از کار بیندازند. وقتی کلودفلر (Cloudflare) اخیراً دچار قطعی خودخواسته شد، کاربران چتجیپیتی از اینکه چتبات قابل اعتمادشان در دسترس نبود، آزرده شدند. ویژگیهای هوش مصنوعی محلی این عیب را ندارند.

تسلط ابر

به نظر میرسد همه موافقند که رویکرد ترکیبی برای ارائه ویژگیهای واقعاً مفید هوش مصنوعی (با فرض وجود چنین ویژگیهایی) ضروری است، و در صورت لزوم دادهها را به سرویسهای ابری قدرتمندتر ارسال میکند گوگل، اپل و هر سازنده گوشی دیگری این کار را انجام میدهند.

اما پیگیری تجربه یکپارچه میتواند آنچه با دادههای شما اتفاق میافتد را نیز پنهان کند. اغلب اوقات، ویژگیهای هوش مصنوعی در گوشی شما به روشی امن و محلی اجرا نمیشوند، حتی زمانی که دستگاه سختافزار لازم برای انجام این کار را داشته باشد.

به عنوان مثال، وانپلاس 15 جدید را در نظر بگیرید. این گوشی دارای اسنپدراگون 8 الیت نسل 5 کاملاً جدید کوالکام است، که NPU آن 37 درصد سریعتر از مدل قبلی است، هرچند این مقدار اهمیت داشته باشد.

حتی با تمام این قدرت هوش مصنوعی روی دستگاه، وانپلاس به شدت به فضای ابری برای تجزیه و تحلیل دادههای شخصی شما وابسته است. ویژگیهایی مانند AI Writer و AI Recorder برای پردازش به سرورهای این شرکت متصل میشوند، سیستمی که وانپلاس به ما اطمینان میدهد کاملاً امن و خصوصی است.

به همین ترتیب، موتورولا در تابستان گذشته خط جدیدی از گوشیهای تاشو Razr را عرضه کرد که مملو از ویژگیهای هوش مصنوعی از چندین ارائهدهنده هستند. این گوشیها میتوانند اعلانهای شما را با استفاده از هوش مصنوعی خلاصه کند، اما ممکن است تعجب کنید که چه مقدار از آن در فضای ابری اتفاق میافتد مگر اینکه شرایط و ضوابط را بخوانید. اگر Razr Ultra را بخرید، آن خلاصهسازی روی گوشی شما اتفاق میافتد. با این حال، مدلهای ارزانتر با رم و قدرت NPU کمتر از سرویسهای ابری برای پردازش اعلانهای شما استفاده میکنند.

باز هم، موتورولا میگوید این سیستم امن است، اما یک گزینه امنتر میتوانست بهینهسازی مجدد مدل برای گوشیهای ارزانتر آن باشد.

حتی زمانی که یک تولیدکننده تجهیزات اصلی (OEM) بر استفاده از سختافزار NPU تمرکز میکند، نتایج میتواند ناکافی باشد. به Daily Hub گوگل و Now Brief سامسونگ نگاه کنید. قرار است این ویژگیها تمام دادههای گوشی شما را بررسی کرده و توصیهها و اقدامات مفیدی تولید کند، اما به ندرت کاری جز نمایش رویدادهای تقویم انجام میدهند.

در واقع، گوگل به طور موقت Daily Hub را از پیکسلها حذف کرده است زیرا این ویژگی بسیار کم کارایی داشت، و گوگل با Gemini Nano پیشگام در هوش مصنوعی محلی است. گوگل در ماههای اخیر حتی برخی از بخشهای تجربه هوش مصنوعی موبایل خود را از پردازش محلی به پردازش ابری منتقل کرده است.

به نظر میرسد مدلهای «قدرت خام» در حال پیروزی هستند، و این که شرکتها با تعامل شما با سرویسهای ابری محاسباتی خصوصیشان، دادههای بیشتری نیز به دست میآورند، ضرری ندارد.

شاید هر چه گیرتان میآید را بپذیرید؟

علاقه زیادی به هوش مصنوعی محلی وجود دارد، اما تاکنون این علاقه به یک انقلاب هوش مصنوعی در جیب شما منجر نشده است. بیشتر پیشرفتهای هوش مصنوعی که تاکنون دیدهایم، به مقیاس همیشه رو به رشد سیستمهای ابری و مدلهای عمومی که در آنجا اجرا میشوند، وابسته است. کارشناسان صنعت میگویند که کارهای گستردهای در پشت صحنه برای کوچک کردن مدلهای هوش مصنوعی برای کار بر روی گوشیها و لپتاپها در حال انجام است، اما زمان میبرد تا این کار تأثیر بگذارد.

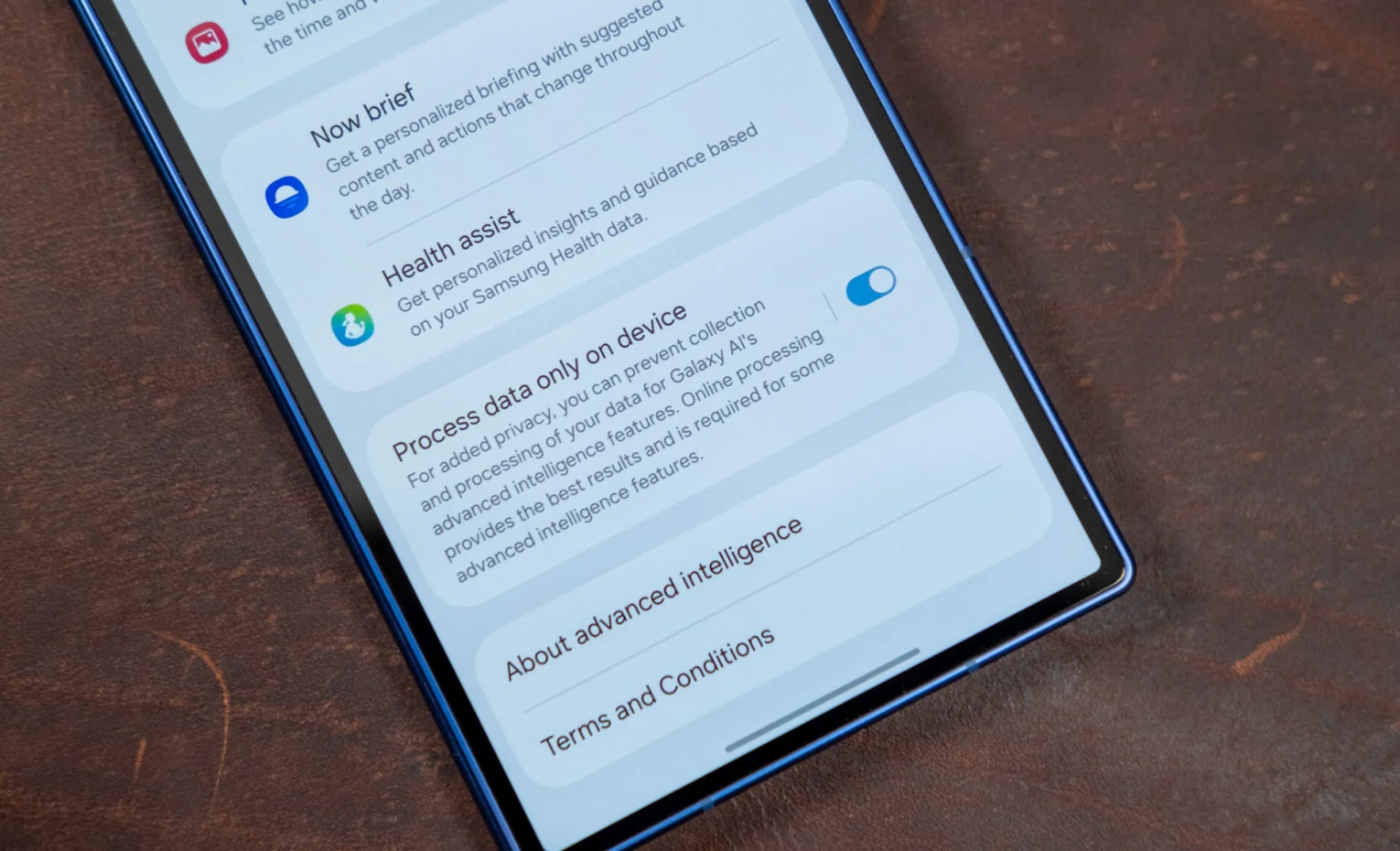

در این بین، پردازش هوش مصنوعی محلی به صورت محدود وجود دارد. گوگل هنوز از NPU تنسور برای مدیریت دادههای حساس برای ویژگیهایی مانند Magic Cue استفاده میکند، و سامسونگ واقعاً بیشترین بهره را از چیپستهای متمرکز بر هوش مصنوعی کوالکام میبرد. در حالی که Now Brief کاربرد مشکوکی دارد، سامسونگ آگاه است که اتکا به ابر چگونه ممکن است بر کاربران تأثیر بگذارد، و گزینهای را در تنظیمات سیستم ارائه میدهد که پردازش هوش مصنوعی را فقط به اجرای روی دستگاه محدود میکند.

این تعداد ویژگیهای هوش مصنوعی موجود را محدود میکند، و برخی دیگر نیز به خوبی کار نمیکند، اما شما مطمئن خواهید بود که هیچ یک از دادههای شخصی شما به اشتراک گذاشته نمیشود. هیچ کس دیگری این گزینه را در گوشی هوشمند ارائه نمیدهد.

سامسونگ یک دکمهی آسان برای غیرفعال کردن هوش مصنوعی ابری و اجرای تمام وظایف روی دستگاه ارائه میدهد.

الیز سمباخ، سخنگوی سامسونگ، گفت که تلاشهای هوش مصنوعی این شرکت بر افزایش تجربهها با حفظ کنترل کاربر استوار است. او گفت: «گزینه پردازش روی دستگاه در One UI این رویکرد را منعکس میکند. این گزینه به کاربران این امکان را میدهد که وظایف هوش مصنوعی را به صورت محلی برای عملکرد سریعتر، حریم خصوصی بیشتر و قابلیت اطمینان حتی بدون اتصال به شبکه پردازش کند.»

علاقه به هوش مصنوعی لبه (edge AI) حتی اگر از آن استفاده نکنید، ممکن است چیز خوبی باشد. برنامهریزی برای این آینده غنی از هوش مصنوعی میتواند سازندگان دستگاه را تشویق کند تا در سختافزار بهتر مانند حافظه بیشتر برای اجرای تمام آن مدلهای نظری هوش مصنوعی سرمایهگذاری کند.

سوکومار گفت: «ما قطعاً به شرکای خود توصیه میکنیم که ظرفیت رم خود را افزایش دهند.» در واقع، گوگل، سامسونگ و دیگران ظرفیت حافظه را تا حد زیادی برای پشتیبانی از هوش مصنوعی روی دستگاه افزایش دادهاند. حتی اگر فضای ابری در حال پیروزی باشد، ما رم اضافی را قبول میکنیم.

پاسخگوی سوالات شما هستیم

دیدگاهی وجود ندارد!